SOU 2016:25 |

Bilaga 2 |

Det är värt att notera den sneda fördelningen i betygsskalan. Den har viss betydelse då den används i beräkningar, t.ex. av genom- snittlig betygspoäng, eftersom skalsteget mellan F och E ger fyra gånger så många betygspoäng som övriga skalsteg. Motivet för utformningen är att betyget E, som innebär godkänt resultat, ska markeras särskilt tydligt.

Grundskolans årskurs 9

Betygsskillnader varierar över tid och mellan ämnen

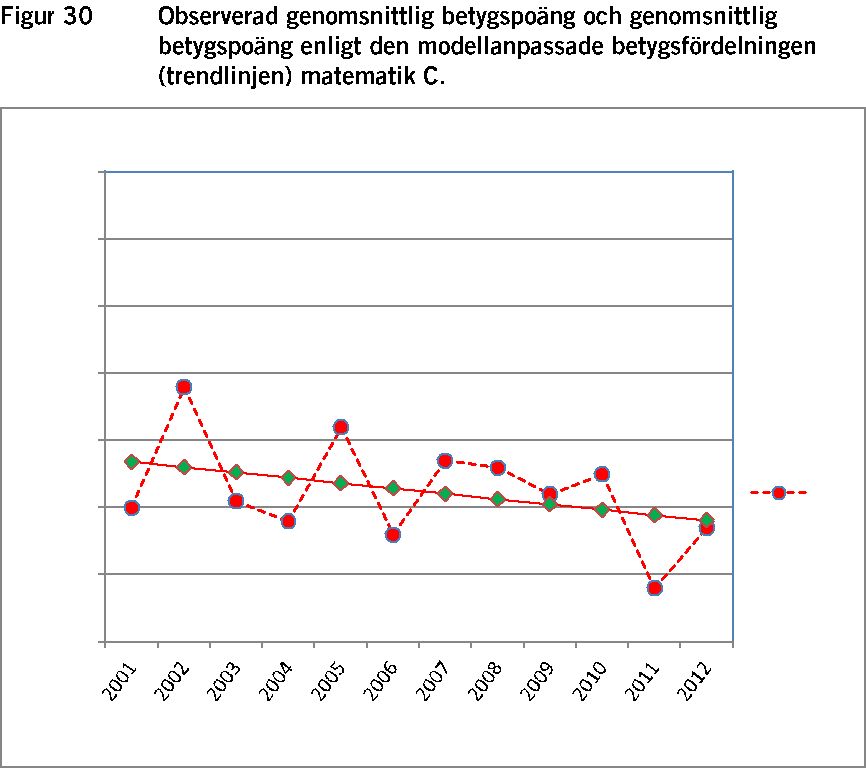

Provresultat och relationen mellan provbetyg och lärarbetyg redo- visas på lite olika sätt av Skolverket. Ett vanligt sätt är diagram av det slag som visas i figur 1.5 Diagrammen visar genomsnittlig betygs- poäng (GBP) för provbetyg (Pbet) och lärarbetyg (Lbet) under den tid det funnits nationella prov inom ramen för ett mål- och kun- skapsrelaterat betygssystem. Nedanstående figur visar utvecklingen för ämnet svenska.

5 Ur Skolverket (2015a).

9